A tecnologia tem um papel fundamental no mundo atual, especialmente quando se trata de acessar e coletar dados automaticamente de um site – algo que um crawler, ou robô de busca, consegue fazer com proficiência. O crawler, originário do termo inglês “crawling”, é um software amplamente usado na otimização de mecanismos de busca, também conhecida como SEO (Search Engine Optimization). Este rastreador de sites é decisivo quando se trata de indexação de conteúdo na web, tornando os sites acessíveis e visíveis para usuários.

Operado por mecanismos de busca como Google, Bing e Yahoo, esse robô percorre a internet, rastreando códigos de websites, conteúdos digitais, palavras-chave e outros aspectos relevantes. Essas informações são cruciais na formulação de estratégias de análise de SEO e contribuem para a melhoria do desempenho e visibilidade online dos sites.

Compreender o funcionamento do web crawler e sua influência na indexação de conteúdo e no algoritmo de busca é essencial para qualquer estrategista de marketing, profissional de TI ou empresário que deseja ter uma presença digital de destaque.

Principais Pontos a Considerar

- Os crawlers, ou robôs de busca, são softwares que rastreiam automaticamente conteúdo na web.

- Essa ferramenta desempenha um papel fundamental na otimização de mecanismos de busca (SEO), analisando sites e indexando conteúdo relevantes para aumentar a visibilidade na web.

- Os crawlers são operados por mecanismos de busca como Google, Bing e Yahoo.

- O entendimento do funcionamento do web crawler e seu impacto na indexação de conteúdo é crucial para a elaboração de digital eficaz.

Introdução ao Mundo dos Web Crawlers

Na era digital atual, as ferramentas tecnológicas desempenham um papel crucial no crescimento e desenvolvimento de negócios online. Entre todas as ferramentas disponíveis, os web crawlers ou ‘spiders’ se destacam como essenciais para a maximização da presença online e a geração de autoridade em temas e palavras-chave específicas.

Os web crawlers, também conhecidos como crawlers, rastreadores da internet ou ‘bots’, são peças-chave na paisagem digital atual.

Esses bots da web são fundamentalmente sistemas de tecnologia automática que permitem a análise em profundidade de concorrentes e do comportamento do público-alvo. O uso efetivo de um crawler pode ajudar a descobrir lacunas estratégicas e a desenvolver estratégias de marketing digital mais eficazes e impactantes.

- Crawler: É um bot de busca que navega automaticamente pela web, seguindo links e coletando informações de páginas da web. A informação é indexada para futuras consultas e pode ser usada para uma variedade de propósitos, incluindo análise competitiva e investigação digital.

- Rastreador da Internet: Refere-se a spiders que acessam a web para coletar dados. Estes podem ser usados para fins de SEO, para entender como os motores de busca veem seu site, ou para coletar dados em escala.

- Spider: Também conhecido como ‘web crawler’ ou ‘bot’, um spider é um software que os mecanismos de busca usam para varrer a internet e coletar dados.

- Tecnologia Automática: Esta é uma tecnologia que automatiza processos que anteriormente necessitavam de intervenção humana. O uso de tecnologia automática é essencial para melhorar a eficiência e a eficácia das operações digitais.

- Bot: Em termos de internet, um bot é um software aplicativo que executa tarefas automatizadas. Estas tarefas podem ser simples ou complexas, como coletar dados de site ou realizar transações online.

- Investigação Digital: Na era digital, a investigação passou a ser referida como ‘investigação digital’. Este termo abrange uma gama de atividades, incluindo a coleta de evidências digitais, a análise de dados e a apresentação de descobertas.

| Ferramenta | Papel no Mundo Digital |

|---|---|

| Crawler | Coleta e indexa informações de páginas da web para futuras consultas e análise competitiva. |

| Rastreador da Internet | Coleta dados em escala para apoiar análises competitivas e estratégias de SEO. |

| Spider | Navega pela web para coletar dados que os motores de busca usam para indexar e classificar sites. |

| Tecnologia Automática | Aumenta a eficiência e a eficácia das operações digitais, automatizando processos que antes necessitavam de intervenção humana. |

| Bot | Executa uma variedade de tarefas automatizadas online, desde a coleta de dados do site até a realização de transações online. |

| Investigação Digital | Engloba a coleta de evidências digitais, a análise de dados e a apresentação de descobertas. |

Ao compreender a funcionalidade e a aplicação dos web crawlers na otimização da presença online e no desenvolvimento de estratégias de marketing digital eficazes, as empresas podem maximizar seu alcance digital e aumentar suas oportunidades de crescimento no espaço digital.

O Papel Vital dos Crawlers na Visibilidade Online

A crescente digitalização mundial tornou o espaço online um campo de batalha competitivo para empresas. A visibilidade na web e a autoridade online tornaram-se aspectos cruciais para assegurar o sucesso desta competição. Google, Bing, Yahoo e outros motores de busca se tornaram os principais direcionadores de tráfego para sites, com isso as empresas perceberam a importância do rastreamento web e da otimização SEO.

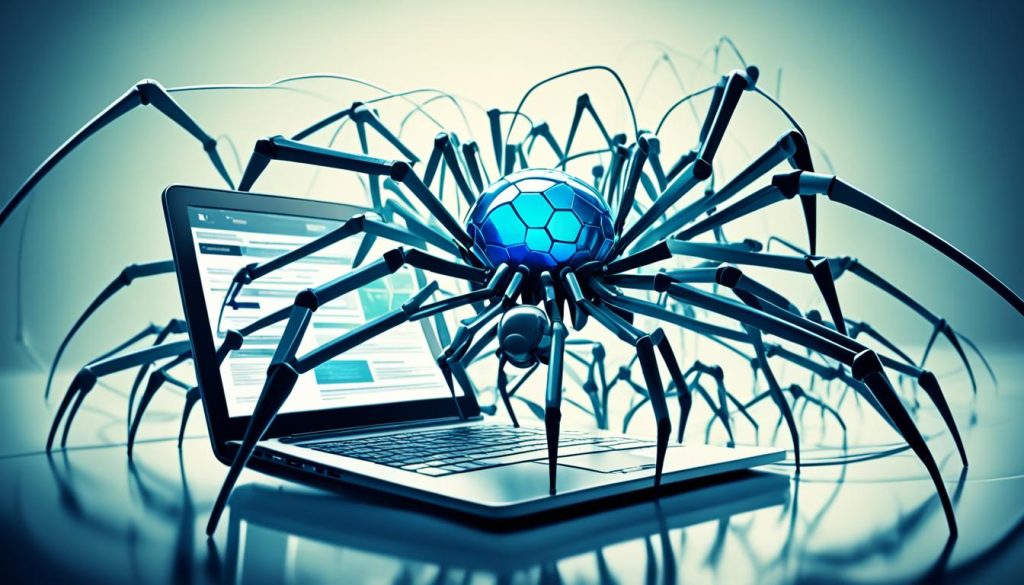

Os crawlers são bots que vasculham a web de maneira sistemática, especialmente úteis para realizar a análise competitiva necessária para destacar um site perante seus concorrentes. Funcionam através do rastreamento de links em dominios, lendo e interpretando conteúdo de acordo com algoritmos de relevância, contribuindo para a construção de indices para motores de busca.

Na prática, é graças a esses rastreadores da web que as pesquisas enviadas aos motores de busca retornam com páginas relevantes para os usuários. Sem o eficiente trabalho dos crawlers, seria quase impossível para as empresas alcançar visibilidade e autoridade online, pois os usuários simplesmente não conseguiriam encontrar seus sites ou páginas.

Compreender o papel vital dos crawlers é, portanto, um passo estratégico para empresas e profissionais que buscam criar uma forte presença online e melhorar sua visibilidade e autoridade. A otimização para motores de busca (SEO) baseia-se em grande parte no trabalho de crawlers, o que torna essencial para as empresas se familiarizar com seu funcionamento para implementar estratégias SEO eficazes.

“Os crawlers são indispensáveis para a visibilidade na web e otimização SEO, sendo uma ferramenta crucial para empresas que pretendem se destacar em um campo digital competitivo.”

Com um entendimento claro do papel vital dos crawlers e um compromisso com a otimização SEO eficaz, as empresas tem a oportunidade de alcançar maior visibilidade na web e ampliar a autoridade de sua marca online.

Anatomia de um Crawler: Como Funcionam os Rastreadores

Entender como operam os crawlers, ou rastreadores, é fundamental para a eficácia na otimização de sites e no alcance de relevância nos motores de busca. Vamos agora descortinar a anatomia de um crawler, e focalizar no processo de rastreamento, na indexação de conteúdo, no papel crucial dos algoritmos, e na interconexão entre diferentes links.

O Processo de Rastreamento e Indexação

Um crawler dá início ao processo de rastreamento a partir de uma lista prévia de URLs conhecidas. De forma automatizada, o crawler navega nessas páginas, buscando hiperlinks que direcionam para outros conteúdos na web, efetuando assim um contínuo processo de rastreamento. Ele identifica e analisa o conteúdo destes, preparando-se para a próxima etapa: a indexação.

Uma vez identificado o conteúdo relevante durante o processo de rastreamento, inicia-se a indexação de conteúdo. Essa fase consiste no armazenamento de informações sobre a página, que serão úteis para apresentar resultados relevantes quando um usuário realizar uma busca na web.

A Interconexão dos Links na Web

Os crawlers são fundamentalmente importantes também no mapeamento da interconexão de links na web. Eles seguem os hiperlinks contidos em cada página, conectando um conteúdo a outro, e assim, expandindo sua capacidade de descoberta e acesso a novas páginas.

Algoritmos e Heurística de Rastreamento

O trabalho de um crawler é orientado por um algoritmo de busca, o conjunto de regras e instruções que guiam suas operações. Esses algoritmos determinam a seleção de quais páginas devem ser rastreadas, a frequência do rastreamento e a profundidade da exploração. Muitos deles, são moldados segundo heurísticas de rastreamento que pontuam as páginas de acordo com a quantidade de links e visitantes, indicando a relevância e importância das informações a serem indexadas.

Compreender todos esses componentes da anatomia de um crawler contribui enormemente para desenvolver estratégias mais eficazes de SEO, alcançando melhores resultados em visibilidade e relevância nos motores de busca.

Os Diversos Tipos de Web Crawlers e Suas Funções

Assim como em qualquer tecnologia, a diversidade é um fator inerente ao vasto mundo dos web crawlers. Dentre eles, podemos identificar alguns tipos específicos, cada um com suas próprias características e funções. Essa variedade permite desempenhar diversas funções, como indexação de conteúdo para motores de buscas, análise estratégica para otimização de SEO e a coleta personalizada de dados para insights específicos de negócios.

Crawlers de Motores de Busca

Os Crawlers de Motores de Busca são talvez os mais conhecidos dentre os diferentes tipos de web crawlers. Esses crawlers, como o Googlebot, Yahoo! Slurp, Baidu Spider e Bingbot, desempenham a crucial função de rastrear e indexar o conteúdo da web nos respectivos motores de busca. Isso garante que quando um usuário realiza uma pesquisa, os resultados mais relevantes sejam apresentados.

Crawlers para Análise de SEO

Os Crawlers para análise de SEO possuem funcionalidades focadas na otimização de websites. Eles auxiliam os profissionais de SEO a identificar potenciais problemas de desempenho, rastrear palavras-chave e fornecer análises aprofundadas que podem melhorar o ranking do site nos motores de busca.

Crawlers Personalizados

Crawlers personalizados são aqueles projetados para extrair dados específicos e fornecer insights altamente estratégicos para empresas. Isso pode incluir informações sobre a concorrência, a análise do comportamento do usuário, a coleta de dados do mercado, entre outros.

Compreender as funções específicas de cada tipo de crawler é fundamental para obter os melhores resultados ao desenvolver e implementar estratégias de SEO. Além disso, reconhecer a importância desses crawlers no atual cenário digital pode ser um diferencial estratégico para qualquer empresa presente na web.

| Tipo de Crawler | Função Principal |

|---|---|

| Crawler de Motores de Busca | Indexação de conteúdo nos motores de busca |

| Crawlers para Análise de SEO | Auxiliar na otimização de sites e na identificação de problemas de desempenho |

| Crawlers Personalizados | Coleta específica de dados para fornecer insights estratégicos para empresas |

Crawlers e SEO: Uma Relação Indissociável

A relação crawler SEO é uma importante dinâmica dentro do universo digital onde um beneficia diretamente o outro. A otimização para mecanismos de busca, comumente conhecida como SEO, depende fortemente dos crawlers para identificar e indexar o conteúdo relevante de um site nos resultados das pesquisas. Da mesma forma, os crawlers dependem do SEO para determinar quais páginas e informações precisam ser rastreadas e indexadas.

Uma eficaz estratégia de SEO visa tornar um site mais amigável para os bots dos mecanismos de busca, tornando o conteúdo facilmente acessível e compreensível para eles. Esta tática é crucial para melhorar a visibilidade online do site e, consequentemente, aumentar o tráfego e o engajamento dos usuários.

“Investir em SEO é vital para crescer a visibilidade no mundo digital e atender às expectativas e interesses do público-alvo.”

Uma estratégia de SEO bem estruturada cuidadosamente planeja e desenvolve conteúdo relevante para o site, alinhando-o com as diretrizes dos mecanismos de busca e as necessidades dos usuários. Este conteúdo relevante é então identificado pelos crawlers, que o indexam nos motores de busca para ser exibido nos resultados de pesquisa.

| Componentes | Implicações para Crawlers | Benefícios de SEO |

|---|---|---|

| Palavras-chave otimizadas | Facilita a identificação e indexação de conteúdo relevante pelo crawler | Aumenta a visibilidade nos motores de busca, atraindo tráfego orgânico |

| Conteúdo de alta qualidade | Proporciona valor para os crawlers, melhorando as chances de indexação | Melhora o engajamento do usuário, aumentando o tempo gasto no site |

| Backlinks de qualidade | Os crawlers veem os backlinks como endossos de autoridade, o que ajuda na indexação | Aumenta a autoridade do site e a classificação nos motores de busca |

No final das contas, a relação entre SEO e crawlers é simbiótica, onde ambos trabalham em conjunto para o propósito comum de melhorar a visibilidade online e a experiência do usuário em um determinado site.

Maximizando a Experiência do Usuário Através do Crawler

A experiência do usuário na web pode ser potencializada significativamente com a ajuda de crawlers. Eles oferecem uma ampla gama de benefícios, incluindo otimizações de tags e estrutura de código, o que são fundamentais para a usabilidade e uma navegação eficiente e prazerosa. Vamos explorar em profundidade a importância da usabilidade no rastreamento e como otimizar um site para crawlers.

Importância da Usabilidade no Rastreamento

A usabilidade é um fator chave para a experiência do usuário e para as taxas de conversão. Os crawlers podem analisar e indexar um site com base nos diferentes aspectos de usabilidade, incluindo a estrutura de código, navegação, web design responsivo e velocidade de carregamento. Ao melhorar esses aspectos, você pode ajudar os crawlers a entender melhor o seu site e, portanto, melhorar seu SEO técnico e a experiência do usuário geral.

Otimização de Sites para Crawlers

A otimização para crawlers é outro aspecto crucial na experiência do usuário. Se um site é devidamente otimizado para crawlers, ele será rastreado e indexado mais eficiente e rapidamente, o que pode levar a um melhor desempenho nos motores de busca. Um site otimizado para crawlers deve levar em consideração fatores como a estrutura de código limpo, uso de tags adequadas, um sitemap atualizado, links internos bem estruturados, e muito mais.

É importante notar que a otimização para crawlers é uma parte importante de qualquer estratégia de SEO técnico. Não basta apenas ter um bom conteúdo, é necessário também garantir que os crawlers podem rastrear e indexar o seu site de forma eficiente.

| Fatores Relevantes para a Otimização para Crawlers | Benefícios Potenciais |

|---|---|

| Estrutura de código limpo | Facilita a tarefa dos crawlers e pode melhorar o tempo de carregamento do site |

| Uso de tags adequadas | Ajuda os crawlers a entender o conteúdo do site |

| Sitemap atualizado | Guias crawlers para as páginas importantes do site |

| Links internos bem estruturados | Torna mais fácil para os crawlers encontrar e indexar todas as páginas do site |

Nos parágrafos acima, a importância da usabilidade e da otimização de um site para crawler foi enfatizada. Lembre-se sempre de que um bom SEO técnico não se baseia apenas em palavras-chave relevantes ou na quantidade de conteúdo. A forma como o site é criado, mantido e otimizado para crawlers e usuários também é de grande importância.

Crawlers Como Ferramentas de Competitividade Digital

Na atualidade, os web crawlers são vitais como ferramentas de rastreamento, gerando insights significativos que energizam estratégias digitais potentes. Impulsionando a competitividade digital, esses programas automatizados são o coração da coleta prolífica de dados que impulsiona um conhecimento empresarial mais profundo, culminando em soluções mais relevantes e tráfego qualificado.

O diferencial não reside apenas na capacidade de coletar dados, mas na forma como esses dados são utilizados para gerar insights. Em uma abordagem cada vez mais centrada no cliente, a capacidade de entender e antecipar as necessidades do cliente se tornou um imperativo comercial.

| Ações dos Crawlers | Impactos na Competitividade Digital |

|---|---|

| Coleta automática de dados | Facilita o entendimento sobre o mercado e o comportamento do público, permitindo um planejamento estratégico mais eficaz. |

| Identificação de palavras-chave relevantes | Auxilia na elaboração de conteúdo otimizado para SEO, melhorando o ranqueamento em mecanismos de busca e atraindo tráfego qualificado. |

| Análise da concorrência | Oferece insights valiosos sobre as estratégias de concorrentes, possibilitando adequações estratégicas para aumentar a competitividade. |

Com os crawlers como aliados poderosos, as empresas são equipadas com ferramentas robustas para deixar sua marca distinta na arena digital. Em um ambiente cada vez mais competitivo, os crawlers fornecem o impulso tecnológico necessário para aumentar a visibilidade online, atrair mais visitantes e, finalmente, converter mais negócios.

Assim, os web crawlers provam ser indispensáveis para empresas modernas que buscam sobreviver e prosperar no ambiente digital acelerado de hoje. A partir de um maior entendimento do mercado, da análise do comportamento do público e da capacidade de agilizar ações, eles são, sem dúvida, ferramentas indispensáveis para aumentar a competitividade digital.

Rastreamento x Privacidade: Entendendo os Limites

Na era digital em que vivemos, a quantidade de informações que são coletadas e analisadas é enorme, marcas e empresas usam as tecnologias oferecidas, como os web crawlers, para rastrear a web e coletar dados. No entanto, é importante lembrar dos limites éticos e legais ligados a essa prática.

Políticas de Rastreamento e Ética na Web

Os web crawlers são ferramentas poderosas para coleta de dados, por isso, adequa-se às políticas de rastreamento a fim de garantir respeito à privacidade na web. Na coleta de informações, é necessário ter transparência, indicando claramente os dados que estão sendo coletados e como serão utilizados. Dessa forma, estabelecer políticas de rastreamento claras e éticas são passos cruciais para manter uma operação digital responsável e respeitosa.

Legislação Aplicável aos Crawlers

Em relação à legislação de proteção de dados, especialmente no contexto brasileiro, a Lei Geral de Proteção de Dados Pessoais (LGPD) define regras claras sobre o que é permitido no rastreamento de usuários na web. Para as empresas que utilizam web crawlers, a conformidade legal não é apenas desejável, mas obrigatória. Respeitar a legislação é um passo crucial para garantir que as atividades de rastreamento estejam dentro dos parâmetros legais e éticos.

| Aspectos | Considerações |

|---|---|

| Políticas de Rastreamento | Devem ser claras, transparentes e baseadas em princípios éticos. A informação sobre a coleta de dados deve estar disponível para os usuários. |

| Conformidade Legal | A adesão à LGPD e outras legislações de proteção de dados é uma necessidade absoluta ao usar web crawlers para coleta de informações. |

| Privacidade na Web | A privacidade do usuário deve ser mantida em todas as instâncias. As práticas de rastreamento devem ser projetadas para proteger a privacidade do usuário. |

Em resumo, enquanto os web crawlers oferecem uma série de benefícios e permitem ampliar a visibilidade online e otimizar a experiência do usuário, a privacidade na web, as políticas de rastreamento, a ética digital, a legislação de proteção de dados e a conformidade legal, sempre devem ser considerados na sua utilização.

A Influência dos Crawlers na Indexação de Conteúdo

Os Crawlers são fundamentais no processo de indexação de conteúdo nos mecanismos de busca. Eles seguem certos critérios e diretrizes, que incluem a qualidade dos backlinks e o tráfego do site, para priorizar as páginas a serem indexadas. Esta seção expandirá mais sobre esses critérios e também sobre a importância dos backlinks no processo de rastreamento.

Critérios para Indexação nos Mecanismos de Busca

Os Crawlers seguem determinados critérios estabelecidos pelos mecanismos de busca para indexar o conteúdo na web. Eles não apenas rastreiam sites em busca de novos conteúdos, mas também avaliam o valor de cada página baseado em diversos sinais. Alguns desses critérios incluem a relevância do conteúdo, a autoridade do site, a experiência do usuário no site, e muitos outros.

O impacto dos Backlinks no Rastreamento

Os backlinks desempenham um papel crucial no processo de rastreamento. Eles não apenas ajudam a aumentar a autoridade de um site, mas também indicam aos Crawlers para rastrear e indexar páginas adicionais. Consequentemente, uma estratégia de SEO off-page eficaz é essencial para conseguir backlinks de sites com autoridade, melhorando assim a visibilidade e o posicionamento nos resultados de busca.

| Fator | Influência na Indexação |

|---|---|

| Conteúdo relevante e de qualidade | Alta influência |

| Backlinks de relevância e autoridade | Alta influência |

| Estrutura do Site | Media influência |

| Performance do site | Media influência |

| Fatores técnicos (HTTPS, velocidade, etc) | Baixa influência |

Tecnologia e Inovação: Os Avanços dos Web Crawlers

Os crawlers, tradicionalmente conhecidos por sua função em indexar páginas para mecanismos de busca, estão passando por uma revolução tecnológica. Com o desenvolvimento de software e a automação de processos, novas funções e capacidades são adicionadas a essas ferramentas de maneira constante. A inteligência artificial, particularmente, tem tido um impacto muito substancial sobre os avanços tecnológicos nessa área.

Com o uso de IA, os crawlers estão se tornando mais eficientes e precisos. Eles agora são capazes de processar informações de maneira mais rápida e exata, o que potencializa significativamente a inovação em crawlers. Isso tem transformado a maneira como a informação é coletada e processada na web, com resultados que beneficiam todos os usuários.

A automação de processos também tem desempenhado um papel importante nesses avanços. Agora, é possível programar crawlers para realizar tarefas específicas automaticamente, sem a necessidade de intervenção humana. Isso significa que eles podem funcionar 24 horas por dia, 7 dias por semana, aumentando assim a eficiência e reduzindo o tempo para coleta de informações.

A inovação em crawlers não mostra sinais de desaceleração. O desenvolvimento constante de software e hardware mais potentes, combinado com os avanços na inteligência artificial, sugere que os crawlers se tornarão ainda mais precisos e eficientes no futuro. Isso representa uma grande promessa para empresas e profissionais que dependem da coleta e análise de dados online para suas operações.

Web Crawlers e Big Data: Entendendo a Relação

No panorama digital atual, a relação entre web crawlers e big data tem assumido uma importância primordial. Web crawlers, ao varrerem a internet, conseguem acumular uma vasta quantidade de informações. No entanto, é a análise dessas informações que permite transformá-las em ‘big data’. Isso significa que é a partir da análise de dados, que conseguimos criar conclusões significativas e estratégias eficientes, baseadas em fatos e números concretos.

Integração de Crawlers com Análise de Dados

Não basta apenas acumular dados, é necessário analisar e interpretá-los. Aqui é onde a análise de dados entra em cena. Esse processo envolve diversas técnicas e métodos para coletar, organizar, e decifrar os dados, transformando-os em informações úteis e estratégias acionáveis. Nesse contexto, os web crawlers desempenham um papel crucial na mineração de dados para coletar e organizar informações úteis.

A importância dos Dados Estruturados para os Crawlers

Dados estruturados são incrivelmente importantes para os web crawlers, pois eles dependem desses para interpretar corretamente o conteúdo de um site e indexá-lo de maneira eficaz nos motores de busca. Os dados estruturados são um formato de dados que ajuda os crawlers a entenderem melhor o conteúdo de uma página e são uma importante ferramenta de inteligência de mercado.

| Benefícios dos Dados Estruturados | Impacto na Análise de Dados |

|---|---|

| Melhora a interpretação do conteúdo pelo crawler | Possibilita uma análise de dados mais precisa |

| Ajuda na indexação da página | Facilita o processo de mineração de dados |

| Aumenta a visibilidade do site nos motores de busca | Melhora o desempenho em estratégias de inteligência de mercado |

No final das contas, o uso efetivo de web crawlers ao lado do big data pode ajudar as empresas a obter uma vantagem competitiva significativa, fornecendo insights valiosos e permitindo-lhes tomar decisões baseadas em dados. Isso é essencial para ter sucesso no ambiente online altamente competitivo e em constante mudança de hoje.

Ferramentas e Softwares de Crawler Disponíveis no Mercado

No ambiente digital, uma infinidade de ferramentas de crawler e softwares de rastreamento torna-se indispensável para o sucesso da estratégia digital de qualquer empresa. Desde análise de SEO a monitoramento de concorrentes e otimização de operações de dados, essas ferramentas proporcionam insights valiosos, auxiliando na análise competitiva e na automatização de dados.

| Nome da Ferramenta | Funções Principais |

|---|---|

| Screaming Frog | Ferramenta de rastreamento de websites, auxilia na auditoria e análise técnica de SEO. |

| Apifier | Solução de crawling baseada em nuvem, ideal para automação e extração de dados. |

| DataparkSearch | Software de spidering e busca, apropriado para indexação de conteúdo na web. |

| HTTrack | Ferramenta de download de website, permite copiar websites para visualização offline. |

Todas estas opções possuem seus próprios conjuntos de funcionalidades e aplicabilidades, variando conforme a necessidade específica do usuário. E, da mesma forma, todas elas desempenham um papel crucial na otimização do desempenho do website e na busca efetiva pela competitividade no espaço digital.

O Futuro do Crawler e Seus Impactos na Busca Orgânica

O crescente aumento da necessidade de dados estratégicos e a consequente evolução das ferramentas de rastreamento apontam para um futuro promissor para os Web Crawlers. Desde a melhoria da eficiência na detecção da busca orgânica até a capacidade de prever o comportamento online dos usuários, várias inovações tecnológicas estão no horizonte

Inovações em Rastreamento e Predição de Comportamento Online

Atualmente, os avanços em tecnologia de rastreamento estão permitindo um rastreamento mais eficiente e detalhado na web. Observem-se ferramentas de rastreamento que podem prever o comportamento do usuário online, analisando tendências de busca, preferências do usuário e respondendo com conteúdo relevante, aperfeiçoando a experiência geral de busca orgânica.

O futuro dos Crawlers entrelaça-se imediatamente com o avanço da tecnologia e a inovação em inteligência artificial. Estas tecnologias permitem uma análise mais rica de dados, que finalmente resulta em uma experiência de usuário mais personalizada e um marketing mais eficaz.

Os Desafios Futuros para os Web Crawlers

Apesar das inovações promissoras no horizonte, os Web Crawlers também enfrentam novos desafios. Como a web continua a expandir-se exponencialmente, o rastreamento eficiente e a indexação se tornam cada vez mais desafiadores. Além disso, questões de privacidade e conformidade com a regulamentação também estão se tornando foco de atenção, particularmente em relação à coleta e uso de dados pessoais na web.

| Web Crawlers | Inovações Futuras | Desafios |

|---|---|---|

| Otimização de Busca Orgânica | Ferramentas de rastreamento que podem prever o comportamento do usuário online. | Regulamentações mais rigorosas em relação à coleta e uso de dados pessoais na web. |

| Rastreamento Eficiente | Mais precisão no rastreamento devido a avanços tecnológicos. | Expansão exponencial da web criando uma sobrecarga de informações para rastrear e indexar. |

À medida que nos aproximamos do futuro do crawler, é imperativo tomar consciência dos avanços em inovação de rastreamento, bem como entender os novos desafios que esses avanços trazem consigo. Estar na vanguarda desse desenvolvimento significa estar preparado para se adaptar e evoluir junto com a tecnologia.

Otimizando seu Site para o Rastreamento Eficiente dos Crawlers

A otimização de site é uma necessidade imperativa na era digital atual. Garantir a eficiência de rastreamento através dos web crawlers exige atenção aos detalhes e uma sólida compreensão de SEO técnico. É crucial investir tempo e esforço na estrutura do site, na velocidade de carregamento, na responsividade e no conteúdo relevante.

Trabalhar a estrutura do site implica em organizar a arquitetura da informação de maneira sensata e fácil de navegar, tanto para os usuários quanto para os crawlers de busca. A velocidade de carregamento do site também é de extrema importância, porque os crawlers tendem a evitar sites que demoram muito para carregar.

A responsividade refere-se à capacidade do site se adaptar a diferentes tamanhos de tela e dispositivos, um fator cada vez mais importante à medida que a busca por dispositivos móveis continua a crescer. O conteúdo relevante é a espinha dorsal de qualquer estratégia de SEO. Isso significa criar conteúdo que seja útil, informativo e valioso para o seu público-alvo.

Além disso, uma análise de SEO detalhada pode indicar melhorias de desempenho. Isso envolve avaliar o desempenho atual do site, analisar as áreas que precisam ser aprimoradas e implementar as mudanças necessárias. Uma vez implementadas, estas melhorias podem aumentar a chance de seu site ser indexado e bem ranqueado pelos mecanismos de busca, maximizando a sua visibilidade online.

FAQ

O que é um crawler e sua importância na internet?

Um crawler, também conhecido como rastreador ou robô de busca, é um software que acessa automaticamente sites para coletar dados. Importantes na otimização para mecanismos de busca (SEO), os crawlers são responsáveis pela indexação de conteúdos e o aumento de visibilidade dos sites na web ao serem pesquisados em buscadores. Eles são essenciais para traçar estratégias de marketing digital e melhorar o tráfego e as oportunidades de um site.

Como os crawlers funcionam?

Um crawler inicia o processo de rastreamento por uma lista de URLs conhecidas, ao seguir hiperlinks identifica o conteúdo a ser indexado. Os mecanismos de busca utilizam algoritmos que determinam quais e com que frequência as páginas devem ser rastreadas, levando em consideração a quantidade de links e visitantes para indicar a relevância e importância das informações a serem indexadas.

Quais são os diferentes tipos de web crawlers?

Existem diversos tipos de web crawlers, cada um desempenhando funções distintas. Crawlers de motores de busca como Googlebot, Yahoo! Slurp, Baidu Spider e Bingbot são essenciais para indexar conteúdo na web; os para análise de SEO ajudam a otimizar sites; e os personalizados podem extrair dados específicos e fornecer insights estratégicos para empresas.

Como os web crawlers influenciam a experiência do usuário?

Os web crawlers potencializam a experiência do usuário na web ao facilitar as otimizações de tags e a estrutura de código, elementos fundamentais para uma navegação eficiente e prazerosa. Além disso, a otimização de um site para crawlers envolve atenção em fatores como responsividade e velocidade de carregamento, impactando diretamente na usabilidade.

O uso de web crawlers está sujeito a alguma legislação?

Sim, o uso de crawlers deve respeitar a privacidade e a ética na web, obedecendo a legislações como a Lei Geral de Proteção de Dados (LGPD) no Brasil. Isso ajuda a prevenir violações de dados e assegura a coleta de informações de maneira legal e ética.

Como os crawlers influenciam na indexação de conteúdo?

Os crawlers seguem critérios dos mecanismos de busca, como qualidade de backlinks e tráfego para priorizar as páginas na indexação. Isso evidencia a importância de estratégias de SEO off-page, como a obtenção de backlinks de sites com autoridade, para melhor posicionamento nos resultados de busca.

Quais são as tendências futuras para os web crawlers?

Os crawlers estão em constante evolução tecnológica, com aprimoramentos em automação de processos e uso de inteligência artificial. O futuro dos crawlers é promissor, com inovações que podem revolucionar a busca orgânica, incluindo avanços em rastreamento e predição de comportamento online.

Como posso otimizar meu site para o rastreamento eficiente dos crawlers?

Para otimizar um site para o rastreamento eficiente dos crawlers, é necessário investir em SEO técnico, focando em aspectos como a estrutura do site, velocidade de carregamento, responsividade e conteúdo relevante. Uma análise de SEO detalhada pode indicar melhorias de desempenho e aumentar a chance do site ser indexado e bem classificado pelos mecanismos de pesquisa.